SGD回帰とは

SGD回帰は、確率的勾配降下法を用いて回帰モデルのパラメータを最適化する手法です。通常、単回帰として使用されますが、複数の説明変数を考慮する場合もあります。SGD回帰では、データセット全体ではなく、ランダムなサンプル(ミニバッチ)を使用してパラメータの更新を行います。これにより、大規模なデータセットでも高速かつ効率的な学習が可能となります。

SGD回帰の特徴

SGD回帰には以下のような特徴があります。

効率性

SGD回帰はランダムなサンプルを使用してパラメータを更新するため、データセット全体を使用する必要がなくなります。そのため、大規模なデータセットに対しても高速な学習が可能です。

オンライン学習

SGD回帰はオンライン学習に適しています。新しいデータが入力されるたびに、ミニバッチを使用してパラメータを更新することができます。これにより、モデルをリアルタイムで更新し、変化するデータに迅速に対応することができます。

モデルの解釈性

単回帰の場合、SGD回帰モデルの解釈は比較的容易です。ただし、複数の説明変数を考慮する場合、解釈が複雑になる可能性があります。

重回帰との違い

SGD回帰と重回帰の主な違いは以下の通りです。

学習アルゴリズムの違い

- SGD回帰: SGDアルゴリズムを使用してパラメータを最適化します。ランダムなサンプルを使用してパラメータを更新し、最小化すべき損失関数を見つけます。

- 重回帰: 最小二乗法や最尤推定法などの手法を使用して、説明変数と目的変数の関係を最適化します。データセット全体を使用してパラメータを更新します。

説明変数の数

- SGD回帰: 通常、説明変数は1つのみです。単回帰として使用されます。

- 重回帰: 複数の説明変数を考慮します。目的変数に与える影響を複数の変数でモデル化します。

モデルの複雑さ

- SGD回帰: SGD回帰は、ランダムなサンプルを使用してパラメータを更新するため、モデルの複雑さは比較的低くなります。

- 重回帰: 複数の説明変数を考慮するため、より多くのパラメータを持つことがあり、モデルの複雑さは高くなります。

モデルの解釈性

- SGD回帰: 単回帰の場合、SGD回帰モデルの解釈は比較的容易です。ただし、複数の説明変数を持つ場合、解釈が複雑になる可能性があります。

- 重回帰: 複数の説明変数を考慮するため、モデルの解釈はより複雑になる傾向があります。変数間の相互作用や重要度を理解する必要があります。

SGD回帰のサンプルコード

下記がSGD回帰のサンプルコードとなります。sklearnにSGDRegressorがあるので、こちらにて分析することが可能です。

import numpy as np

from sklearn.model_selection import train_test_split

from sklearn.linear_model import SGDRegressor

from sklearn.datasets import load_iris

from sklearn.preprocessing import StandardScaler

from sklearn.metrics import mean_squared_error

# Irisデータセットをロード

iris = load_iris()

X = iris.data

y = iris.target

# 特徴量を正規化

scaler = StandardScaler()

X_scaled = scaler.fit_transform(X)

# データをトレーニングセットとテストセットに分割

X_train, X_test, y_train, y_test = train_test_split(X_scaled, y, test_size=0.2, random_state=42)

# SGD回帰モデルの作成

sgd_reg = SGDRegressor(max_iter=1000, eta0=0.01, random_state=42)

# モデルのトレーニング

sgd_reg.fit(X_train, y_train)

# テストデータで予測

y_pred = sgd_reg.predict(X_test)

# モデルの評価

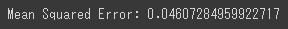

mse = mean_squared_error(y_test, y_pred)

print(f"Mean Squared Error: {mse}")

まとめ

SGD回帰は、確率的勾配降下法を使用して効率的に回帰モデルを学習する手法です。SGD回帰はランダムなサンプルを使用し、オンライン学習にも適しています。一方、重回帰は複数の説明変数を考慮し、モデルの複雑さや解釈性が高くなります。適切な手法の選択は、データセットの性質や解析の目的に応じて行う必要があります。SGD回帰は大規模なデータセットやリアルタイムな学習に向いており、重回帰は複数の説明変数を考慮する際に有用です。重回帰は変数間の相互作用や重要度を解釈する必要があります。

コメント